En à peine six décennies, l’Intelligence Artificielle est devenue omniprésente. En complétant la force, la précision et l’endurance surhumaine des machines par une intelligence qui dépasse largement la nôtre pour un nombre croissant de tâches, elle inaugure le « deuxième âge de la machine ». Dans cet article, Patrick Albert montre que si son histoire est scientifique et industrielle, elle est aussi militaire, capitalistique et maintenant éthique et géopolitique.

L’intelligence artificielle est née avec l’informatique aux États-Unis dans les années 1950, mais son histoire « officielle » commence avec la célèbre « École d’été de Dartmouth » organisée par les mathématiciens, John McCarthy et Marvin Minsky, pour réunir pendant six semaines une vingtaine de chercheurs en informatique, cybernétique, électronique, philosophie et linguistique, afin de fonder ce nouveau domaine, lui donnant son nom et son objectif initial : simuler l’intelligence humaine. L’objectif s’est depuis généralisé à toute forme d’intelligence, telles celles qui organisent la matière, ou animent les bactéries, virus, plantes et animaux, en particulier les animaux sociaux. Son horizon putatif est la supra-intelligence[1].

Apprendre à parler, savoir écrire, coopérer

À l’origine, deux approches sont en compétition : l’une s’apparente à la façon dont nous apprenons à parler – tout simplement par l’exemple et la pratique, en écoutant et en parlant –, tandis que la seconde s’apparente à l’apprentissage de l’écriture par mémorisation d’un corpus de règles et d’exceptions formalisé par des experts : les linguistes.

Dans la première approche de nature probabiliste, dite « connexionniste », la machine construit elle-même son modèle de décision, par induction, en « digérant » des milliers et jusqu’à des millions d’exemples qu’un humain aura sélectionnés. Les exemples peuvent être des images, des textes, de la musique, des profils de personnes… Dans la seconde méthode, dite « symbolique », c’est un humain qui fait le travail de formalisation de la « base de connaissances » généralement représentée par un ensemble de règles de décision de type « si … alors … ». Une troisième approche enfin, dite « multi-agents », a ensuite émergée et est en forte croissance, modélise le travail en équipe, car en intelligence artificielle aussi, l’union fait la force.

Intelligence comme apprentissage

La méthode probabiliste prend son essor en 1957 avec le Perceptron qui informatise une modélisation simplifiée des neurones. Dès 1959, une IA gagne au jeu des dames après avoir appris en jouant contre elle-même, créant ainsi ses propres données d’apprentissage ! Mais les succès restent très limités, car les temps d’apprentissage rédhibitoires empêchent le domaine de décoller. Il faudra attendre la réunion de trois facteurs : amélioration des algorithmes, accélération hardware et plus encore parallélisation massive des calculs, et enfin la profusion « d’exemples » disponibles sur le web. En 2010, la base d’apprentissage ImageNet rassemblant des millions d’images fédère la communauté « apprentiste » autour d’une compétition annuelle, et c’est en 2012 qu’un réseau de neurones d’un nouveau genre – l’apprentissage profond – crée l’évènement en devançant largement tous ses compétiteurs. Puis ça va très vite… En 2015, les IA comprennent les images plus vite que les humains, et de même pour la transcription de la parole en 2016, année où le programme AlphaGo bat le champion du monde du jeu de Go par 4 parties à 1. C’est le début du succès mondial de l’IA reposant sur les réseaux neuronaux « profonds » dont la taille explose littéralement, jusqu’à contenir plus de 3000 milliards de paramètres. Ils sont déjà le moteur d’innombrables applications : recommandation de livres, de vidéos ou musique, voiture autonome, robots industriels et de service, compréhension et création de textes, de musiques, d’images, etc. etc.

Intelligence comme raisonnement

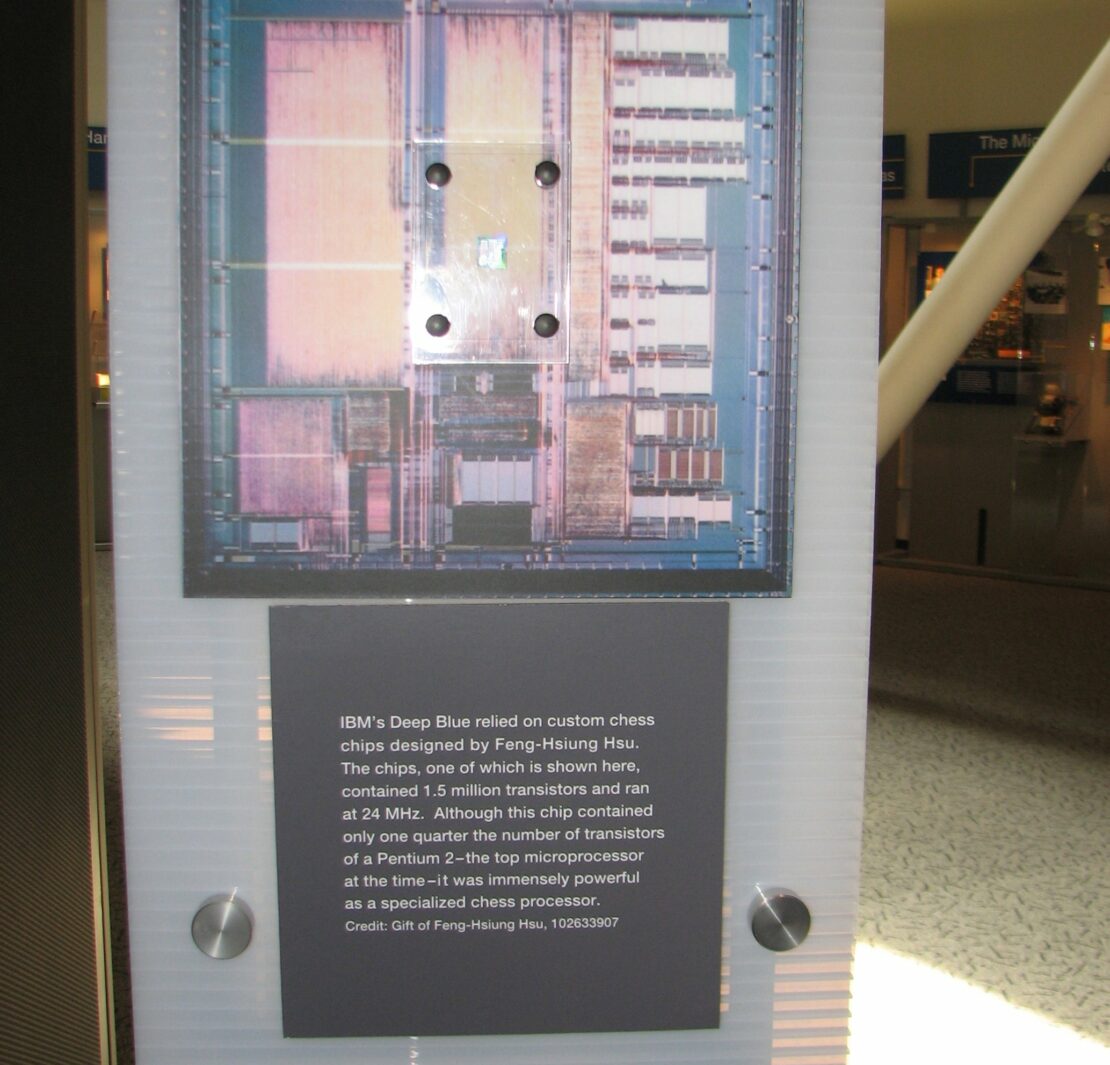

En 1965 le premier chatbot – ELIZA – voit le jour, qui simule un psy menant des entretiens thérapeutiques, puis c’est au mitan des années 1980 que l’on assiste à un premier essor industriel avec la vague des « Systèmes Experts » qui automatisent le raisonnement en utilisant des centaines ou des milliers de règles extraites de l’expertise du domaine. Ça fonctionne, mais la maintenance de ces bases de règles s’avère trop difficile, et la mode s’essouffle… jusqu’en 1997 lorsque la victoire de Deep Blue d’IBM contre le champion du monde des échecs démontre qu’un important cap est franchi. L’automatisation à base de ce que l’on appelle dorénavant les « règles métiers » se déploie alors à bas bruit dans les télécoms, la banque et l’assurance. En 2011, IBM frappe fort à nouveau en gagnant le jeu Jeopardy version américaine de « Questions pour un champion ». L’IA s’est émancipée du monde étriqué des 64 cases de l’échiquier pour aborder le vaste univers du langage et de la culture générale. Sous le nouveau nom de RPA – Robot Process Automation –, l’IA symbolique pénètre dans l’industrie, l’administration et les services pour conférer fiabilité et robustesse à ce que l’on appelle les « décisions de routine » qui ne requièrent qu’une très bonne connaissance de la tâche.

Intelligence comme coopération

Entre temps, partant du constat que l’intelligence est une propriété non seulement des individus, mais aussi des collectifs, humains ou non, une troisième branche de l’IA faisait discrètement son chemin, celle des « agents intelligents ». Née aux États-Unis dans les années 1970, cette approche pour partie « bio-inspirée » formalise des modèles de coopération[2], voire d’auto-organisation d’ensembles d’agents composés de quelques unités ultra-spécialisées jusqu’à quelques milliers, peu sophistiqués mais totalement coopérants. La robustesse est son principal avantage, car si un ou plusieurs agents se trompent ou même disparaissent, d’autres serrent les rangs et poursuivent les opérations. Les essaims de drones, inspirés des nuées d’oiseaux, des bancs de poissons ou des colonies de fourmis en sont les exemples les plus spectaculaires, comme cet essaim de 1824 drones parfaitement coordonnés qui a inauguré les Jeux Olympiques de Tokyo 2020, ou comme les essaims militaires, documentés par le journal New Scientist, utilisés par Israël pour localiser, identifier et attaquer des combattants palestiniens durant la guerre contre Gaza en mai 2021.

Aujourd’hui, l’histoire des sciences, techniques et applications de l’IA s’accélère : alors que toutes ces méthodes restent très imparfaites, leur maîtrise est devenue un formidable enjeu de puissance tant militaire qu’économique.

Financement et géopolitique de l’IA

L’IA n’est pas un phénomène hors-sol, elle sert à transformer nos sociétés, et l’histoire de son financement nous aide à comprendre dans quelles directions. C’est donc le très influent Institut Rockfeller qui a subventionné l’évènement fondateur, l’« école d’été de Dartmouth », pour aussitôt passer le relai à l’armée américaine restée à peu près seule aux commandes jusqu’aux années 1990[3]. À coups de millions de dollars, l’armée sélectionnait les méthodes d’IA à développer, et surtout, définissait les objectifs à atteindre : traduction automatique (du Russe vers l’Anglais…), interprétation des images et du « signal », planification de missions et robotique. Pour ne prendre que quelques exemples emblématiques, Google Translate, SIRI l’assistant vocal d’Apple, ou encore la « voiture autonome », ont été voulus, et initialisés ou soutenus par la tête de pont scientifique de l’armée états-unienne : la DARPA – Defense Advanced Research Projects Agency. Dans l’esprit de ses commanditaires, c’est à un char d’assaut que ressemblait cette « voiture » reprise ensuite par Google, embauchant en 2009 un des grands vainqueurs des courses organisées par la DARPA. Les autres pays ont suivi comme, par exemple, la Russie où la « voiture », nommée T-14 est bien un tank.

La première poignée de chercheurs en IA a utilisé la doctrine de « suprématie scientifique et technologique » des militaires états-uniens en suscitant des espoirs tels que l’armée lui a assuré la croissance éclair à l’origine de sa suprématie mondiale. Mais les promesses étaient irréalistes (voire farfelues ![4]) et ne pouvaient être tenues, à deux reprises les militaires ont craqué, coupant les crédits et déclenchant des « hivers de l’IA », ainsi qu’on les a nommés. Le premier dure de 1973 jusqu’en 1981 lorsque le Japon se lance dans l’IA avec un plan de 850 millions de dollars, déclenchant aussitôt une réponse états-unienne à hauteur de 1 milliard de dollars, toujours pilotée par l’armée ; en France, l’IA ne concernait alors que quelques dizaines d’universitaires. Suit un nouvel hiver en 1987 long d’une petite dizaine d’années. Puis c’est dans les années 2010 que la spectaculaire percée de l’approche connexionniste, avec « l’apprentissage profond » (ou Deep Learning), propulse l’IA jusqu’aux étoiles, et déclenche en particulier la mobilisation massive de Google[5] et Amazon suivis de Facebook[6] (maintenant Meta). Depuis ce moment de bascule, si les budgets militaires restent des leviers de tout premier plan pour orienter les recherches en amont – 100 millions d’€/an en France pour la Loi de programmation militaire 2019-2025, et 2 milliards de dollars pour le plan « AI Next » de la DARPA lancé en 2019 – ce sont les dizaines de milliards du capital privé qui décident des méthodes à optimiser et des applications à déployer. La nomination en 2016 d’Eric Schmidt, PDG historique de Google, à la présidence du « Defense Innovation Advisory Board » qui conseille l’armée américaine sur la technologie est un exemple emblématique de l’alliance entre États et entreprises privées autour de ce que l’on appelle maintenant les « technologies duales », un concept qui a pour effet la transposition systématique des technologies de guerre dans nos existences, car pour financer leur course à l’IA, les militaires ont besoin que nous utilisions, ou subissions, les versions démilitarisées de leurs applications.

Plus de 60 pays ont mis en ordre de bataille leurs ministères de la défense, de l’intérieur, de la recherche et de l’industrie pour organiser et financer leur filière IA selon une « feuille de route IA », comme la France en mars 2018. Toutefois, l’asymétrie reste brutale car les États-Unis et la Chine mobilisent à eux seuls 80% des investissements mondiaux annuels, tandis que l’Europe ne compte que pour 7%. Les méga-firmes transnationales de l’IA telles Google, Microsoft, Amazon et Facebook/Meta disposent de moyens à la hauteur de leur volonté de domination mondiale grâce auxquels ils mènent l’IA, en partenariat toujours étroit avec la Maison Blanche. Ou du moins, la mènent encore… car la victoire de Google au jeu de Go a réveillé la Chine, c’était une grossière erreur stratégique ! Majoritairement composé d’ingénieurs, le gouvernement chinois a compris le danger, faisant aussitôt de l’IA une priorité absolue, si bien qu’en juillet 2017, la Chine a dévoilé une feuille de route très simple : devenir d’ici 2030 le centre d’innovation mondial en IA. Et on peut y croire, car la qualité et le nombre des scientifiques chinois est au service de la volonté des dirigeants de prendre leur revanche sur la colonisation toujours présente dans les mémoires. Les BATIX[7] qui sont les jumeaux chinois des GAFAM commencent à leur damer le pion. Les États-Unis, à leur tour, alertés en 2019 par un rapport percutant du Comité de Défense mentionné plus haut, réalisent qu’ils pourraient perdre la course à l’IA, dont Vladimir Poutine avait annoncé dès 2017 que « Celui qui deviendra leader en ce domaine sera le maître du monde ». On assiste à une accélération inédite dont les motivations hélas ne sont pas vraiment le bien de l’humanité…

Le développement de l’IA états-unienne, et donc mondiale, s’est largement produit au service d’applications militaires dont nous utilisons ou subissons les avatars. Notre « profilage » indécent par Facebook, Google et leurs concurrents est le déploiement civil des IA de « ciblage » conçues pour l’armée américaine et la NSA, tout comme l’usage policier de la reconnaissance faciale[8], des drones et des robots-chiens[9] ne sont que quelques exemples de la « valorisation » civile des applications militaires aux origines de l’IA. Et si la Chine est à juste titre montrée du doigt, elle n’est en réalité que l’arbre qui cache mal une forêt toujours plus dense.

Nous payons le prix du péché originel de l’IA, car l’intelligence humaine s’exerce dans de très nombreux domaines, et d’autres modalités de financement auraient produit d’autres usages de l’IA.

Reste « l’Éthique », ultime rempart du citoyen, et nouveau champ de la géopolitique de l’IA. En décembre 2019, l’Agence des droits fondamentaux de l’Union européenne dénombrait plus de 260 documents, textes et chartes éthiques au niveau mondial. Mais ce rempart tient plutôt du rideau de fumée car ces comités, tous « consultatifs et non contraignants », occupent essentiellement deux rôles : les comités « sponsorisés » par le privé aident les lobbies à bloquer, ralentir, ou amoindrir la production de normes par les États, tandis que les comités d’éthique publics habillent de grandes « valeurs » des normes laxistes au service du dogme de la « liberté d’innover et d’entreprendre ». À ce titre, la position en 2021 de la Commission Européenne est exemplaire : sa proposition législative « se limite aux exigences minimales nécessaires pour répondre aux risques et aux problèmes liés à l’IA, sans restreindre ou freiner indûment le développement technologique ni augmenter de manière disproportionnée les coûts de mise sur le marché de solutions d’IA ». L’extraordinaire accélération des investissements civils et militaires, habillée de l’invraisemblable prolifération de chartes et comités d’Éthique indique l’urgence du contrôle par la population de la poursuite de l’histoire de l’IA. L’affaire est d’importance, car nous assistons impuissants à la naissance du deuxième âge de la machine.