big data

Afin de dépasser l’opposition entre technosceptiques et tenants du scientisme, Hugo Pompougnac nous invite à analyser le basculement scientifique et technologique induit par la généralisation de l’intelligence artificielle au prisme du marxisme et du matérialisme. Le débat se recentre ainsi sur ses effets sur la division du travail entre travail mort – l’automatisation amenée à dominer – et travail vivant, les forces productives et leur avenir. L’enjeu de la mobilisation de ces innovations technologiques par les exploités ouvre alors de nouvelles perspectives en vue de leur émancipation et d’un changement révolutionnaire.

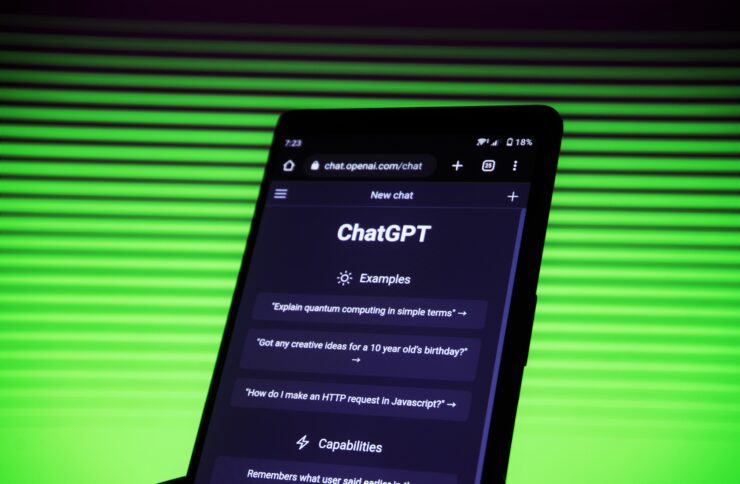

Disponible pour le public depuis fin novembre 2022, le robot conversationnel ChatGPT est rapidement devenu un symbole de la présence chaque jour plus imposante de l’intelligence artificielle dans nos vies. Dans cet article, Aurélie Biancarelli nous invite à interroger notre rapport aux savoirs et à l’apprentissage qui se trouve profondément changé avec l’utilisation de cet outil. Produisant des réponses consensuelles à partir de la collecte de grandes quantités d’informations, l’un de ses dangers réside dans la complexité et l’opacité des technologies de deep learning qu’il met en œuvre et dans l’instrumentalisation à des fins idéologiques que peuvent en faire les classes dominantes. Pour ne pas tomber dans ces écueils, il est ainsi essentiel de replacer la pensée critique et rationnelle au centre des apprentissages et d’assurer la maîtrise démocratique de ces nouveaux outils dont toute interdiction est vaine.

Les méthodes informatiques de calcul – souvent appelées « algorithmes » – alimentent le fonctionnement de dispositifs ordinaires. Moteurs de recherche, réseaux sociaux, systèmes de surveillance, plateforme d’achats en ligne : qu’on le veuille ou non, nous ne cessons d’interagir avec ces systèmes numériques ainsi qu’avec les algorithmes qui fondent leurs mécanismes internes. Comment reprendre la main sur ces entités souvent présentées (à raison) comme opaques, arbitraires et vectrices d’inégalités ? En se basant sur les résultats d’enquêtes ethnographiques récentes, Florian Jaton propose de se focaliser sur les bases de données référentielles – souvent appelées ground truth – qui sont au fondement du travail de construction algorithmique.

La croissance exponentielle du numérique et de son empreinte carbone nous mène-t-elle dans l’impasse ? Si des avancées technologiques promettent un numérique plus sobre, les applications concrètes sont encore peu nombreuses. Pour Sylvain Delaitre, il est donc urgent de limiter l’inflation des données, la production effrénée et très polluante de matériels électroniques et de replacer les enjeux technologiques et industriels associés dans le cadre de la délibération démocratique. L’implication des salariés, des scientifiques, des usagers citoyens dans les prises de décision stratégique permettrait de reconstruire des filières industrielles de technologies de pointe en phase avec les besoins humains et environnementaux.

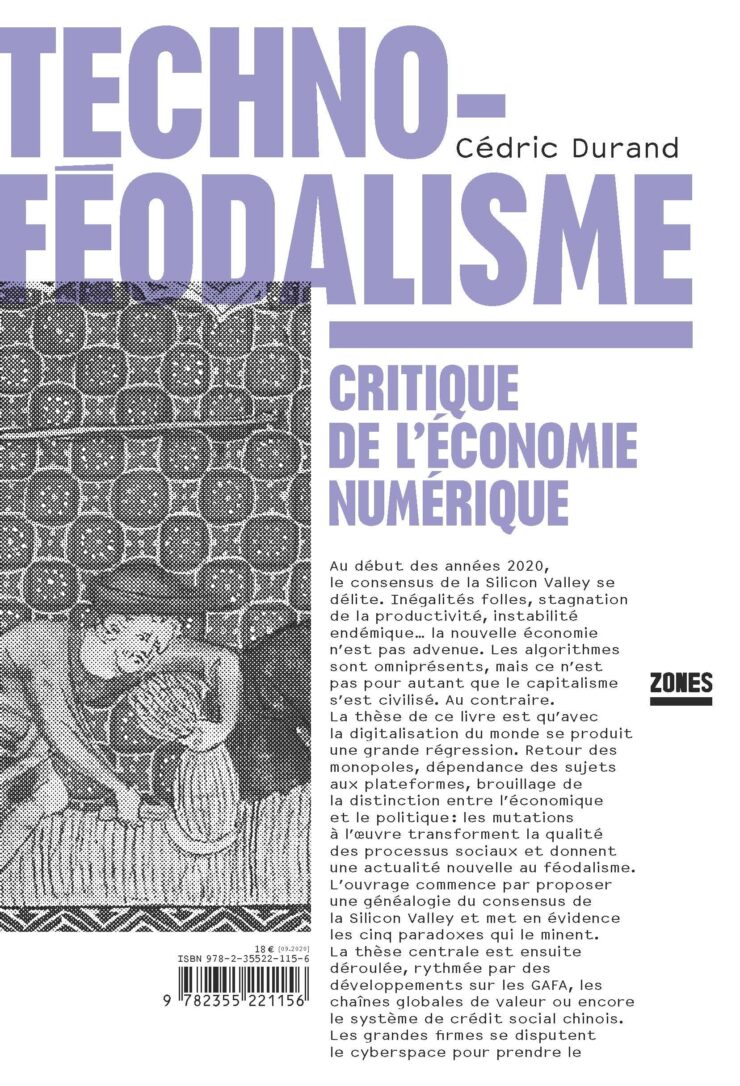

L’essor des technologies numériques participe de la transformation actuelle du capitalisme. Les structures de l’économie des plateformes et la segmentation des grandes firmes en unités autonomes interdépendantes procèdent d’un même modèle réticulaire d’organisation et de transmission de l’information. Dans cet article, Maxime Ouellet montre les liens entre le développement technique des algorithmes et l’idéologie néolibérale. En appréhendant la technologie comme une forme d’objectivation des rapports sociaux, il dépeint comment la gouvernance algorithmique travaille à généraliser une rationalité purement économique en l’imposant au consommateur dans toutes les dimensions de sa vie.